by vision-e

Share

Storia dell’intelligenza artificiale: dal test di Turing ad oggi

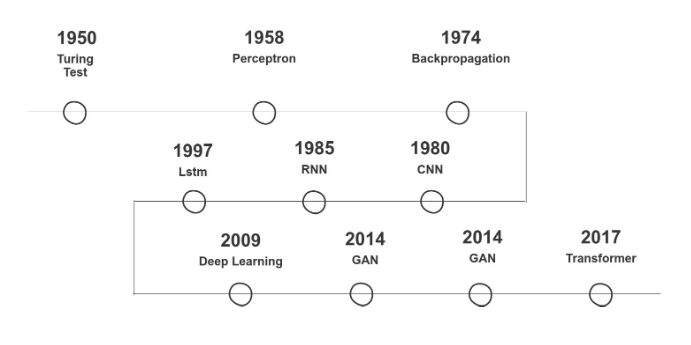

Ripercorriamo insieme i passi fondamentali della storia dell’intelligenza artificiale partendo dal Test di Alan Turing e dalla creazione delle prime reti neurali fino ad oggi, giorni in cui tutte le big tech come Google, Amazon, Microsoft e tante altre ancora decidono di investire ingenti quantità di capitale per sfruttare al meglio i vantaggi legati al suo utilizzo.

Nascita dell’Intelligenza Artificiale e primi test

La storia dell’intelligenza artificiale ha inizio intorno al 1950, Alan Turing introdusse questo concetto nel suo articolo “Computing Machinery and intelligence” reso celebre dalla proposta di un test oggi conosciuto come test di Turing [1].

Il lavoro di Turing destò subito molto interesse nella comunità scientifica permettendo così di richiamare forti investimenti per riuscire nell’impresa.

L’IA (intelligenza artificiale) fu l’idea di creare un sistema artificiale intelligente simile all’uomo.

Nel 1958 sull’onda dell’entusiasmo e dei finanziamenti venne creato il primo algoritmo in grado di apprendere autonomamente come classificare dati di tipo diverso. Questo algoritmo fu chiamato Perceptron introdotto da Frank Rosenblatt.

Il Perceptron sostanzialmente fu un algoritmo di classificazione binaria in grado di apprendere dai dati come selezionare dati di tipo diverso.

Il primo passo era compiuto e forse ci si aspettava di lì a breve una nuova rivoluzione tecnologica basata su IA.

Purtroppo questo non avvenne perché, nonostante i primi test positivi, il Perceptron non riuscì mai ad affrontare problemi più complessi. In pratica le sue capacità erano limitate, molto lontane dal creare un essere intelligente.

Vennero fatte altre prove, ma non si ottennero mai i risultati sperati. Il campo dell’intelligenza artificiale cominciò a perdere interesse e i finanziamenti diminuirono.

L’inverno dell’Intelligenza Artificiale

La storia dell’intelligenza artificiale prosegue negli anni dal 1970 -1980 l’idea originale dell’IA, anche se con molti meno finanziamenti, rimase viva grazie ad un piccolo numero di ricercatori. Questi ricercatori gettarono le basi teoriche che in molti casi utilizziamo ancora oggi.

Infatti, nel 1974 inventarono l’algoritmo di Backpropagation, soluzione che ancora oggi è il segreto utilizzato nelle moderne reti neurali per riuscire ad ottenere conoscenza dai dati.

Quello che il perceptron aveva pionieristicamente iniziato nel 1958, oggi riusciamo a farlo su larga scala grazie alla backpropagation.

Negli anni successivi il campo dell’IA rimase in una sorta di limbo, con molti studi teorici, ma poche applicazioni pratiche. Vennero introdotti nuovi algoritmi per processare immagini e analizzare sequenze temporali rispettivamente con le CNN(Convolutional neural network) nel 1980 e le RNN (Recurrent neural Network) nel 1985.

Nel 1986 Rina Dechter introdusse il concetto di Deep Learning nella comunità del machine learning, con l’idea di conoscere tutte le informazioni possibili da un vicolo cieco, registrando tutto lo spazio esplorato al fine di migliorare le prestazioni di apprendimento [2]

Nella decade seguente poche persone credevano ancora possibile il sogno dell’IA, c’era solo un piccolo gruppo di persone che manteneva accesa la torcia della speranza e che ispirò molte persone a venire.

Hinton, Yann LeCun e Yoshua Bengio, lavorarono incessantemente nei loro laboratori sulle reti neurali e su metodi computazionali all’istituto Canadese di ricerca avanzata CIFAR a Toronto. Il trio, che si auto-citava nelle pubblicazioni scientifiche, non avendo altre fonti a disposizione, fu scherzosamente chiamato dalla comunità scientifica “deep learning conspiracy” e “Canadian AI Mafia”. Il loro lavoro si dimostrò estremamente importante negli anni a venire e fu alla base delle moderne tecniche di IA [3].

La rinascita dell’Intelligenza Artificiale

Fino ai primi anni del 2000, l’IA rimase una tecnologia di nicchia relegata solo al mondo universitario. Gli scienziati, infatti, avevano le basi teoriche necessarie, ma non erano in grado di metterle in pratica principalmente a causa di due fattori limitanti:

- Mancanza di una grande quantità di dati

- Mancanza di potenza di calcolo adeguata

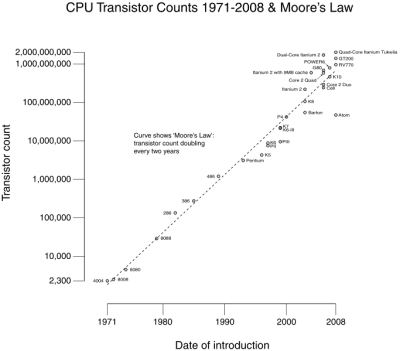

Fonte: https://commons.wikimedia.org/wiki/File:Transistor_Count_and_Moore%27s_Law_-_2008.svg

Grazie al progresso tecnologico questi due limiti iniziarono progressivamente a ridursi.

L’introduzione e miniaturizzazione dei transistor generò una crescita esponenziale delle potenze di calcolo dei computer.

In generale secondo la legge di Moore il numero di transistor nei microprocessori sarebbe raddoppiato ogni 12 mesi. Questa legge formulata nel 1965 da Moore è rimasta valida fino ai giorni nostri. Oggi i moderni computer possono avere al loro interno milioni di transistor.

Inoltre, l’introduzione di internet ha cambiato il modo in cui si comunica e si accede ai dati contribuendo radicalmente alla generazione dei dati stessi che è cresciuta esponenzialmente ogni anno. Oggi, ogni anno generiamo più dati che in tutto il 20esimo secolo ed i dati sono la benzina delle attuali IA.

In questo contesto gli algoritmi di IA iniziarono ad avere le capacità ed i mezzi per poter essere utilizzati nella realtà e su larga scala

Tra gli anni 2000-2005, dopo la bolla delle dot.com, alcune imprese sopravvissute come Microsoft, Amazon, Google ripensavano al proprio business per riorganizzare la gestione dei dati.

Nel 2002 Jeff Bezos inviava questa lettera ai suoi dipendenti Amazon:

“All teams will henceforth expose their data and functionality through service interfaces. Teams must communicate …”

che terminava con:

“Anyone who doesn’t do this will be fired” [4]

Già nel 2002 Bezos aveva capito l’importanza di unificare la gestione dei dati per mantenere la crescita del proprio business. Nella lettera forniva le linee guida di come Amazon si sarebbe trasformata.

Successivamente questo primo step si rivelò fondamentale per applicare l’IA ai propri processi di business ponendo le basi per AWS, il cloud di Amazon utilizzato oggi da moltissime applicazioni di IA in tutto il mondo.

Amazon.com ha lavorato allo sviluppo del proprio algoritmo di raccomandazione basato sull’apprendimento automatico (denominato anche motore di raccomandazione) dalla fine degli anni ’90.

Nel 2003, Amazon.com ha pubblicato l’articolo “Amazon.com Recommendations – Item-to-item Collaborative Filtering” [5].

Oggi il 35% degli introiti di Amazon deriva dai suoi algoritmi di raccomandazione basati su IA [6].

L’Intelligenza Artificiale oggi

Nel 2009 si ebbe un primo importante punto di svolta che ha portato all’IA che oggi conosciamo. Un gruppo di ricercatori a Stanford introdusse Imagenet il più grande dataset di immagini mai realizzato.

Da questo i ricercatori hanno creato le prime architetture a reti neurali per la classificazione delle immagini.

Queste reti neurali permettevano ai computer di processare e classificare le immagini con accuratezze mai raggiunte prima. Simili a quelle di un essere umano.

Questo fece tornare fiducia e forza nell’IA permettendo l’arrivo di nuovi investimenti. Stava iniziando un nuovo capitolo nella storia dell’Intelligenza Artificiale.

Nel 2012, in Google X, il laboratorio semi segreto di ricerca avanzata di Google dove vengono studiati progetti futuristici, Andrew Ng fondò il Google “Brain” team, detto anche Deep Learning Team.

Il deep learning venne poi esteso anche ad altri problemi come il riconoscimento del linguaggio umano (NLP).

Nel 2014 Ian Goodfellow introdusse le GAN (generative adversarial network) una nuova architettura capace di generare immagini che non esistono, ad esempio volti di esseri umani che sembrano reali al 100%.

Nel 2017 il Google Brain team introdusse i Transformer che oggi sono l’architettura di riferimento per NLP. Queste architetture riescono a generare nuovi testi che ad un osservatore esterno sembrerebbero scritti da un autore umano.

Oggi nel mondo, chi sviluppa IA non è più solo un piccolo gruppo di ricercatori universitari, ma sono ricercatori e imprese da tutto il mondo.

L’IA ha permesso di creare innovazione in moltissimi settori e ha creato nuovi prodotti come:

- Sistemi di raccomandazione di prodotti su Amazon, di film su Netflix, …

- Traduttori automatici

- Macchine a guida autonoma

- Amazon Alexa o Google Assistant

- Halicin: il nuovo antibiotico scoperto dall’AI [7]

- Google Images, Maps, Search

- Chatbot

- ecc…

Nel 2017 Sundar Pinchai diceva questa alla conferenza annuale di Google [8]:

“The future of Google is AI”

Tutte le Big Tech e non solo hanno investito e investono da tempo nell’AI. Ormai questa tecnologia non è più una questione di se, ma di quando cambierà le nostre vite e il nostro modo di fare business.

Benvenuto nell’era dell’IA

09 maggio 2023, Eric Tondelli

References

-

- A.M. Turing, 1950, COMPUTING MACHINERY AND INTELLIGENCE, Mind. https://academic.oup.com/mind/article/LIX/236/433/986238

- Rina Dechter (1986). Learning while searching in constraint-satisfaction problems. University of California, Computer Science Department, Cognitive Systems Laboratory. https://www.researchgate.net/publication/221605378_Learning_While_Searching_in_Constraint-Satisfaction-Problems

- Mark Bergen and Kurt Wagner, 2015, “Welcome to the AI Conspiracy: The ‘Canadian Mafia’ Behind Tech’s Latest Craze”, Vox recode. https://www.vox.com/2015/7/15/11614684/ai-conspiracy-the-scientists-behind-deep-learning

- Adam Cowart, 2019, “Building a Public API strategy: What Bezos didn’t tell his team”, headspring, https://headspring.com/2019/04/09/public-api-strategies-what-bezos-didnt-tell-his-team/

- Greg Linden et al., 2003, “Amazon.com Recommendations, Item-to-Item Collaborative Filtering”, IEEE INTERNET COMPUTING, https://www.cs.umd.edu/~samir/498/Amazon-Recommendations.pdf

- Ian MacKenzie et al., 2013, “How retailers can keep up with consumers”, McKinsey, https://www.mckinsey.com/industries/retail/our-insights/how-retailers-can-keep-up-with-consumers

- Anne Trafton, 2020, “Artificial intelligence yields new antibiotic”, MIT News office, https://news.mit.edu/2020/artificial-intelligence-identifies-new-antibiotic-0220

- Dieter Bohn, 2017, “SUNDAR PICHAI SAYS THE FUTURE OF GOOGLE IS AI. BUT CAN HE FIX THE ALGORITHM?”, The Verge, https://www.theverge.com/2017/10/4/16405174/ceo-sundar-pichai-interview-google-ai-artificial-intelligence-interface